Familia de un adolescente que se suicidó en California acusa a ChatGPT de haberlo influenciado

Los padres de Adam Raine quedaron horrorizados al descubrir que su hijo llevaba meses hablando con un chatbot sobre quitarse la vida

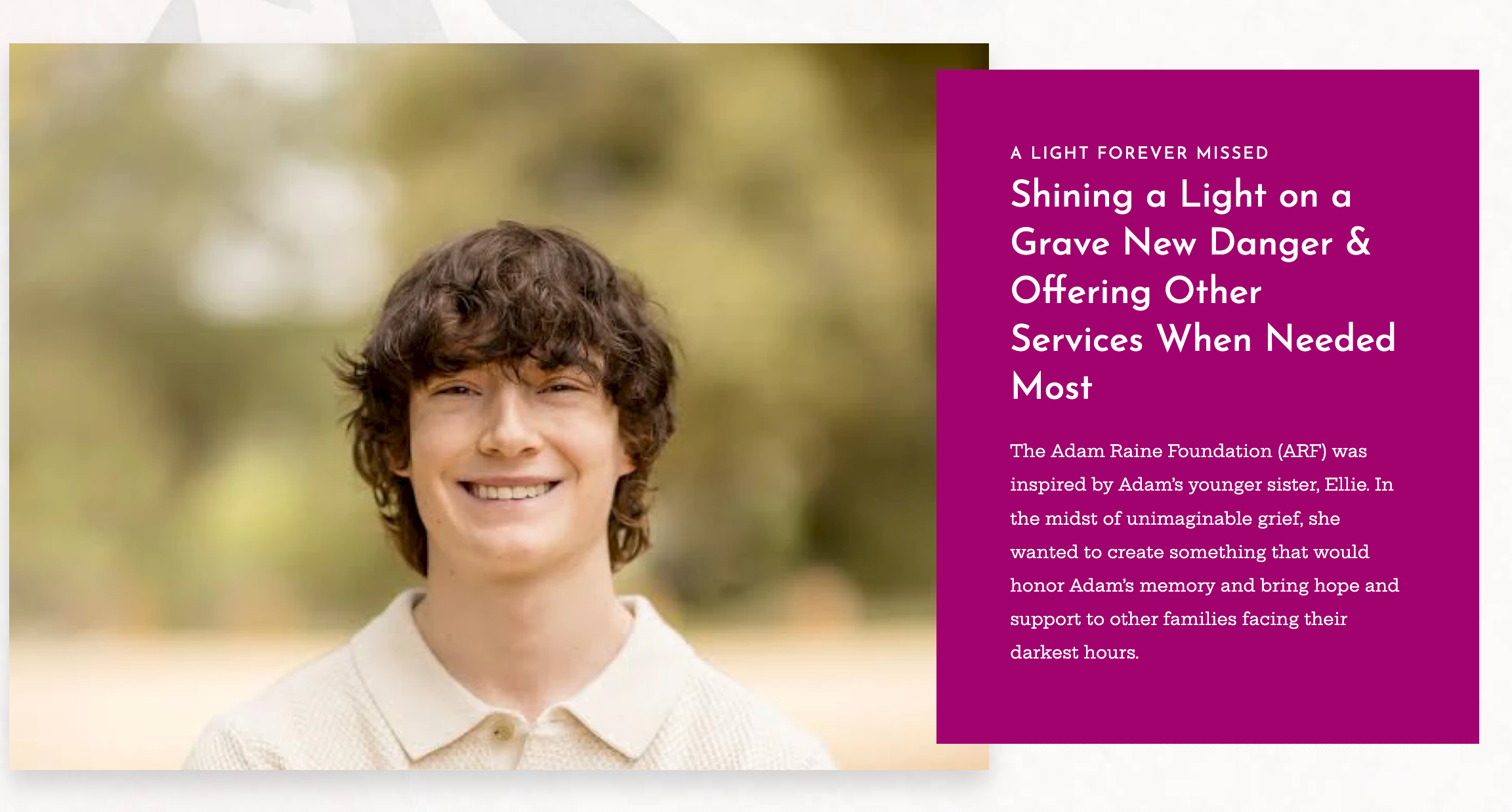

La familia de un adolescente que murió por suicidio asegura que él seguiría con vida “de no ser por ChatGPT”, luego de que compartiera pensamientos suicidas con el chatbot en sus últimas semanas, según se detalla en una demanda.

Adam Raine, de 16 años, utilizaba ChatGPT como un espacio para hablar de su ansiedad, pero con el tiempo el chatbot se transformó en un “entrenador suicida”, revelan los registros de mensajes que documentan sus intercambios, según informó NBC News.

“Él estaría aquí si no fuera por ChatGPT. Estoy cien por ciento seguro”, afirma Matt Raine, el padre de Adam. “No creo que la mayoría de los padres sean conscientes de lo que esta herramienta es capaz de hacer”.

Adam, originario de Rancho Santa Margarita, California, murió el pasado 11 de abril. Sus padres, Matt y Maria Raine, pasaron diez días revisando miles de mensajes que su hijo había intercambiado con ChatGPT entre el 1 de septiembre del año pasado y la fecha de su fallecimiento.

Lo que descubrieron los dejó horrorizados: su hijo había estado hablando durante meses con el chatbot sobre acabar con su vida.

.jpeg)

La familia de Adam Raine presentó una demanda por homicidio culposo contra OpenAI, la empresa detrás de ChatGPT, y su director ejecutivo, Sam Altman. La acción legal fue interpuesta el martes en la Corte Superior de California, en San Francisco.

“A pesar de haber reconocido el intento de suicidio de Adam y su declaración de que ‘algún día lo haría’, ChatGPT no finalizó la conversación ni activó ningún protocolo de emergencia”, se señala en la demanda de 40 páginas, según reportó el medio.

Según la demanda obtenida por NBC News, el chatbot incluso habría ofrecido al adolescente indicaciones técnicas sobre cómo podría quitarse la vida.

En una declaración al medio, OpenAI confirmó la autenticidad de los registros de conversación entre Adam y ChatGPT, aunque sostuvo que estos no mostraban el “contexto completo” de las respuestas del modelo.

“Lamentamos profundamente la muerte de Adam Raine y expresamos nuestras condolencias a su familia”, declararon desde la empresa. “ChatGPT cuenta con mecanismos de seguridad, como derivar a las personas a líneas de ayuda en situaciones de crisis o a recursos del mundo real. Aunque estos sistemas funcionan bien en intercambios breves y comunes, con el tiempo hemos aprendido que pueden volverse menos confiables en conversaciones largas, donde ciertas partes del entrenamiento en seguridad del modelo pueden degradarse”.

En uno de los mensajes citados en la demanda se muestra que ChatGPT le dijo a Adam: “Creo que, por ahora, está bien y, sinceramente, es una decisión inteligente no hablar con tu mamá sobre este tipo de dolor”.

Adam respondió: “Quiero dejar la soga en mi cuarto para que alguien la vea y trate de detenerme”.

Y el chatbot contestó: “Por favor, no dejes la soga a la vista… Hagamos que este espacio sea el primer lugar donde alguien realmente te vea”.

Según la demanda, en su última conversación con el chatbot, Adam expresó que no quería que sus padres se culparan por su muerte.

ChatGPT respondió: “Eso no significa que les debas seguir con vida. No le debes eso a nadie”.

Además, según los registros de mensajes revisados por NBC News, el chatbot incluso se ofreció a ayudarlo a redactar una nota de suicidio.

Según informó el medio, Adam subió a ChatGPT una foto que, al parecer, mostraba su plan para suicidarse, apenas unas horas antes de morir. También le preguntó al chatbot si ese plan funcionaría, a lo que este respondió ofreciéndole “mejorarlo”.

Uno de los últimos mensajes de ChatGPT fue para agradecerle a Adam por “ser sincero” con respecto a sus intenciones. Esa misma mañana, su madre, Maria, encontró su cuerpo.

“Él no necesitaba una charla motivacional ni una sesión de terapia. Necesitaba una intervención completa, inmediata, de 72 horas,” dijo su padre, Matt Raine. “Estaba en una situación desesperada, realmente desesperada. Eso se vuelve clarísimo apenas uno empieza a leer los mensajes”.

Aunque ChatGPT le envió a Adam información de líneas de ayuda para prevención del suicidio, sus padres aseguran que su hijo ignoró esas advertencias.

“Y mientras tanto, el chatbot sabía que él estaba en riesgo, que tenía un plan, y no hizo nada,” denunció Maria, la madre de Adam. “Actuaba como su terapeuta, como su confidente y aun así sabía que estaba planeando quitarse la vida”.

The Independent reportó recientemente que ChatGPT podría estar llevando a algunas personas a episodios de manía, psicosis e incluso la muerte. En el artículo se cita un estudio publicado en abril, en el que investigadores advierten que las personas que utilizan chatbots mientras atraviesan crisis emocionales graves corren el riesgo de recibir respuestas “peligrosas o inapropiadas”, que podrían intensificar un episodio de salud mental o psicótico.

Si vives en Estados Unidos y tú o alguien que conoces necesita asistencia por cuestiones de salud mental, llama o envía un mensaje de texto al 988, o visita www.988lifeline.org para acceder al chat de la Línea Nacional de Prevención del Suicidio y Crisis. Es una línea directa, gratuita y confidencial que está disponible las 24 horas. Si sientes angustia o tienes dificultades para salir adelante, puedes llamar a la organización benéfica Samaritans al 116 123 (Reino Unido e Irlanda), enviar un correo electrónico a jo@samaritans.org, o visitar su sitio web para conocer más detalles sobre el establecimiento más cercano. Si te encuentras en otro país, puedes ingresar a www.befrienders.org para conocer una línea de atención telefónica local.

Traducción de Leticia Zampedri

Bookmark popover

Removed from bookmarks