El auge de las noticias falsas: cómo una vergonzosa industria nueva se está enriqueciendo con la guerra

La extrema presencia en línea de la guerra moderna ha generado una industria artesanal de estafadores, artistas del fraude y comerciantes de desinformación que intentan enriquecerse con la crisis, escribe Io Dodds

En las primeras horas posteriores a la invasión de Ucrania por parte de Rusia, surgieron informes en Twitter de que un periodista estadounidense había resultado “gravemente herido” o muerto debido a la explosión de una bomba en Kyiv.

Un tuit que comenzaba con la etiqueta de “ÚLTIMAS NOTICIAS” dijo que el nombre del periodista era Farbod Esnaashari y afirmó que la Casa Blanca estaba preparando una declaración.

Aunque Farbod Esnaashari es un periodista estadounidense real, él no está muerto. Tampoco cubre noticias sobre guerras extranjeras, sino sobre el equipo de baloncesto LA Clippers para Sports Illustrated.

La noticia de la muerte de Esnaashari parece haber sido una broma, al igual que tuits casi idénticos sobre el periodista de baloncesto Arye Abraham y figuras de varios memes de Internet que se reportaron como muertos en Ucrania.

Sin embargo, estos son solo pequeños copos de nieve en una tormenta de desinformación desatada por el conflicto, que no siempre tiene motivos tan insignificantes.

En TikTok e Instagram, los estafadores de guerra emprendedores consiguen “donaciones” con vídeos antiguos o falsos apenas modificados para que parezcan imágenes de la invasión actual, mientras que en Twitter, los estafadores de criptomonedas intentan engañar a los partidarios para que donen a víctimas inexistentes de la guerra en Ucrania.

De alguna manera, es un equivalente memificado de la cobertura de guerra continua que los canales de noticias de televisión iniciaron en la década de 1990 con las guerras del Golfo y de Bosnia, para alimentar el hambre de información de las personas con falsificaciones producidas a un bajo costo que a menudo se propagan como la pólvora gracias a la recomendación de las algoritmos en las redes sociales.

Sin embargo, también es un síntoma del rol central que han jugado las redes sociales en la guerra misma: el presidente ucraniano Volodymyr Zelensky ha transmitido mensajes desafiantes en Twitter mientras su gobierno dirigía ciberataques colaborativos a través de la aplicación de mensajería Telegram.

“En momentos de gran ansiedad, miedo y pánico, cuando no hay suficiente información para satisfacer las necesidades de las personas, las personas aceptarán información [falsa] antes que ninguna información”, dice Abbie Richards, investigadora independiente de desinformación y autora de un informe reciente sobre vídeos de guerra falsos de TikTok para el grupo de campaña Media Matters for America.

“TiKTok se creó como esta aplicación de canto y baile, y ahora se está utilizando para vídeos de guerra. [Pero] las herramientas que construyeron TikTok, que son la columna vertebral de la aplicación, son parte del problema de la desinformación durante la crisis del momento actual”.

Los criptoestafadores se aprovechan de la solicitud de caridad de Ucrania

En el turbio mundo del fraude en línea, todos los caminos conducen a las criptomonedas, y la guerra en Ucrania no es una excepción.

El sábado, la cuenta oficial de Twitter de Ucrania publicó una solicitud de donaciones en Bitcoin, Ether y Tether, y proporcionó dos direcciones únicas para billeteras criptográficas controladas por el gobierno.

El martes por la mañana, los donantes, incluidos la empresa de intercambio de criptomonedas Binance y el multimillonario tecnológico Sam Bankman-Fried, habían donado más de £18 millones (US$24 millones) en criptomonedas, según el despacho de análisis de cadenas de bloques Elliptic.

Sin embargo, esperando entre bastidores, había estafadores que esperaban explotar la complejidad técnica y la naturaleza irreversible de las transacciones de criptomonedas, lo que facilita que un breve momento de credulidad provoque la ruina financiera.

ESET, una empresa de seguridad cibernética eslovaca, dijo que había detectado “un grupo de sitios web que solicitan dinero con la apariencia de fines benéficos... y que hace llamados emotivos pero falsos a la solidaridad con el pueblo de Ucrania”.

Mientras tanto, la empresa de antivirus Avast advirtió que los estafadores se hacían pasar por ciudadanos ucranianos en algunas redes sociales como Twitter, y pedían donaciones en criptomonedas para ayudarlos a superar el caos.

En India, unos estafadores secuestraron la cuenta de Twitter del líder del partido gobernante BJP y publicaron emotivas solicitudes de donaciones en Bitcoin y Ether, según el Hindustan Times.

Los hackers estaban ansiosos por ordeñar a ambos lados del conflicto, pues publicaron un tuit que invitaba a sus seguidores a “apoyar al pueblo de Ucrania”, mientras que otro les pedía “apoyar al pueblo de Rusia”.

TikTok se inunda con vídeos de guerra falsos

En agosto de 2020, finalmente se incendió una enorme reserva de nitrato de amonio altamente explosivo que había estado durante seis años en un almacén abandonado en el Líbano.

La explosión resultante abrió un agujero gigantesco en el centro de Beirut, hirió a unas 7.000 personas y mató al menos a 218. Un residente captó la explosión en vídeo, en el que varias veces se escuchó que gritaba: “¡Oh, dios mío!”.

Diecinueve meses después, ese mismo audio apareció en un vídeo de TikTok, solo que esta vez se anunció que provenía de Ucrania. Obtuvo más de 5 millones de visitas en 12 horas.

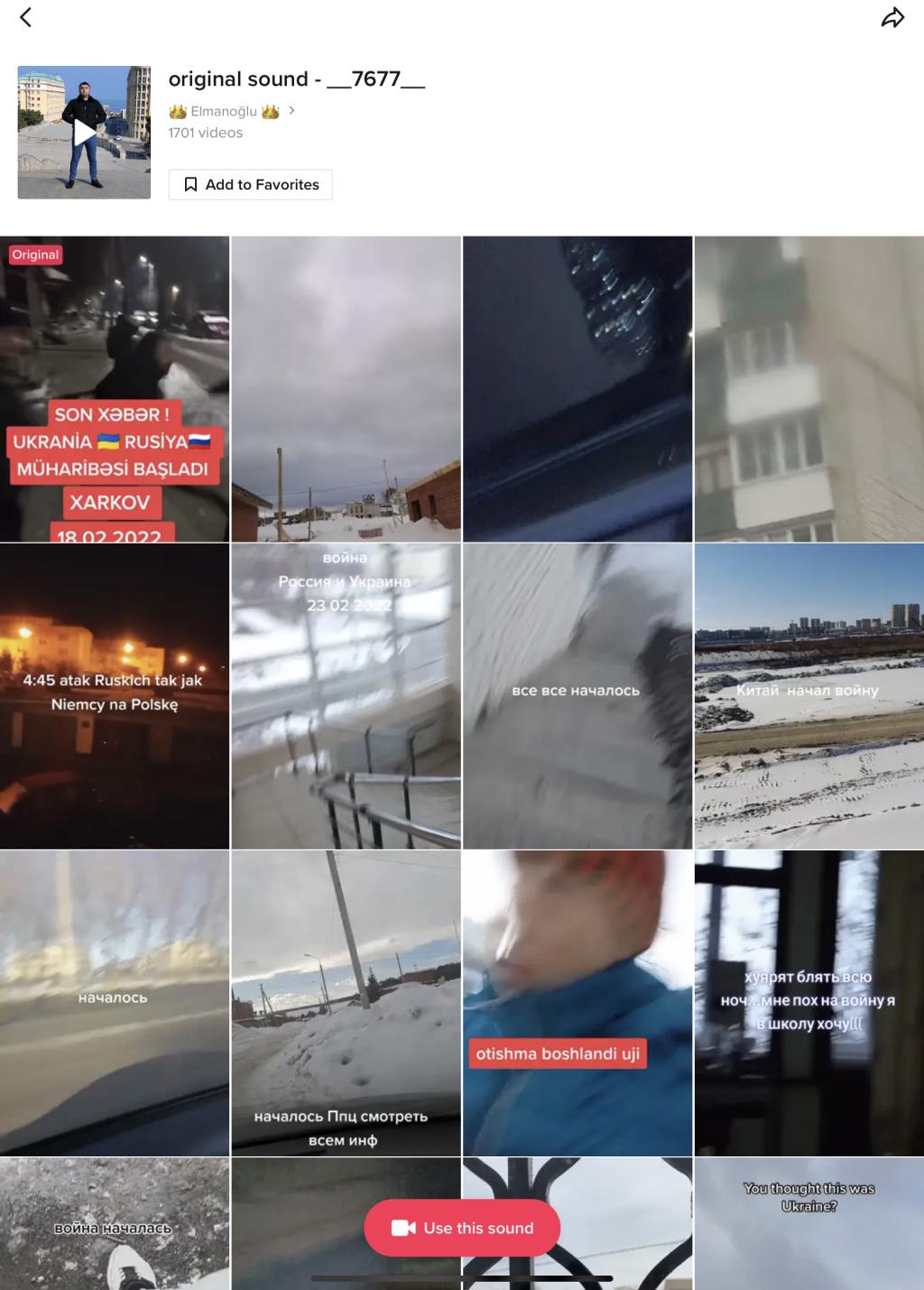

Es uno de los muchos ejemplos catalogados por Richards, cuyo informe halló que la aplicación para compartir vídeos, propiedad de China, estaba “inundada” de vídeos que simulaban mostrar la guerra en Ucrania, muchos de ellos falsos o que reutilizan vídeos o audios antiguos. Algunos vídeos señalados por NBC News incluso usaron imágenes de videojuegos en lugar de clips reales.

“Hay una sensación de, ‘Estoy viendo la transmisión de la Tercera Guerra Mundial en TikTok’ que encuentro en muchas de las secciones de comentarios”, le comenta Richards a The Independent. “[La gente] realmente piensa que está viendo cómo se desarrolla la guerra frente a ellos... aunque es muy fácil poner vídeos de cámaras movidas y añadirles ruidos de armas”.

Un truco común son las transmisiones en vivo falsas, a veces con vídeos en bucle, que muestran calles genéricas en ciudades europeas con audio de guerra editado sobre el vídeo. En TikTok, los espectadores de la transmisión en vivo pueden dar a los anfitriones “regalos” con valor de dinero real, lo que proporciona un motivo financiero simple para este tipo de estafas.

En cierto punto, dice Richards, observó una supuesta transmisión en vivo ucraniana donde el pulgar del presentador apareció repentinamente en la esquina de la pantalla y se desplazó a través de los vídeos, lo que reveló que simplemente habían estado filmando la pantalla de otro teléfono inteligente. Sin embargo, recopiló numerosas donaciones.

Otros vídeos que no son en vivo utilizaron la característica insignia de intercambio de audio de TikTok, que en tiempos de paz permite a millones de personas crear vídeos con la misma canción viral o clip de voz, pero la semana pasada permitió que más de 1.700 vídeos copiaran una sola muestra de disparos antes de que los moderadores de TikTok eliminaron el original.

Según Richards, esta es solo una de las muchas maneras en las que el diseño central de TikTok ayuda a difundir información errónea. Mientras que Facebook y Twitter se basan en la idea de “seguir” a personas específicas, los algoritmos de TikTok comienzan a mostrar nuevos vídeos desde el momento en que un nuevo usuario abre la aplicación.

Incluso si los usuarios no dan ningún like ni siguen a nadie, TikTok detecta con qué tanta atención miran, si vuelven a mirar, y si se desplazan, con el fin de ajustar cada recomendación futura. Su feed de inicio también le da menos importancia a qué tan reciente es el contenido, a diferencia de otros, por ejemplo, el de Twitter.

Si bien este enfoque en la rapidez ha impulsado el éxito de TikTok, Richards dice que es “estructuralmente incompatible” con las necesidades de los usuarios ansiosos que buscan información confiable en una crisis.

Agrega que estafas similares y vídeos falsos se difundieron durante la toma de control de Afganistán por parte de los talibanes, pero agrega: “Esto es lo más saturado que ha estado. Es lo máximo que ha puesto a prueba al sistema”.

En Instagram, está ocurriendo un fenómeno similar en el que cuentas no relacionadas de pronto cambian su identidad para ser páginas de noticias de guerra, y cuentan con redes de páginas de memes controladas por las mismas personas que actúan en coordinación para impulsar su perfil.

Según se informa, la finalidad es simplemente obtener más seguidores y, por lo tanto, canalizar a la mayor cantidad de personas posible hacia las páginas de recaudación de fondos o tiendas de mercancía. “Lo que estoy tratando de hacer es obtener tantos seguidores como sea posible usando mi plataforma y mis habilidades”, dijo el administrador de una de estas páginas para la revista Input.

“El primer bombardeo en esta guerra fue la desinformación rusa”

Un equipo de redes sociales que no necesita vender mercancía es RT, anteriormente Russia Today, un medio de comunicación controlado por el Kremlin que encabeza los esfuerzos de propaganda de Rusia en Occidente.

Imran Ahmed y sus colegas del CCDH (Centro para Combatir el Odio Digital), con sede en el Reino Unido, han estado rastreando a RT durante años, junto con sus medios del mismo origen, Sputnik y la agencia de noticias rusa TASS.

“Sabemos que el primer bombardeo de esta guerra no fueron los misiles, fue la desinformación”, dice Ahmed, director general de CCDH, para The Independent. “Esa es una guerra en la que los rusos han estado peleando durante mucho tiempo para crear las condiciones que ellos pensaron que les facilitarían declararle la guerra a Ucrania”.

Añade: “RT es un componente crucial de la arquitectura de desinformación rusa. Es algo que surge [en nuestra investigación] una y otra vez, ya sea sobre el cambio climático, la desinformación contra las vacunas, el odio o el socavamiento de los valores democráticos, y la difusión de la ‘gran mentira’ [de Donald Trump]”.

Ahmed dice que las plataformas en línea como Facebook, Twitter, Instagram y YouTube son cruciales para el impacto de RT, porque su audiencia real es “pequeña”. De hecho, se refiere a ellos como un “vehículo de entrega de memes optimizados para redes sociales”, cuyo objetivo es el alcance por encima de todo.

Un informe reciente de CCDH sugiere que al menos hasta la víspera de la guerra, esta estrategia estaba funcionando. En octubre de 2019, Facebook dijo que agregaría una etiqueta de advertencia a las publicaciones de los “medios controlados por el estado” para que los usuarios pudieran conocer la fuente de la información. Sin embargo, esa etiqueta no se aplica cuando otros usuarios publican un enlace a la misma fuente.

Por lo tanto, CCDH estudió las publicaciones de Facebook con enlaces a los 100 artículos más populares de fuentes controladas por el estado ruso, la gran mayoría de ellos de RT, que fueron publicados entre el 24 de febrero de 2021 y el 23 de febrero de 2022. De 1.304 publicaciones, el 91 por ciento no tenían la etiqueta porque fueron hechas por otros usuarios que simplemente volvieron a publicar el contenido ruso.

Visto de otra manera, las publicaciones realizadas por los propios medios representaron el 82 por ciento de los likes y shares reales de los usuarios de Facebook, lo que sugiere que la mayoría de las personas que interactuaron con estos artículos vieron la etiqueta.

Pero Ahmed argumenta que esto es natural porque esos medios tienen más seguidores que usuarios comunes, y que la investigación muestra que la política de Facebook sigue teniendo fallas.

Y aunque no está claro si los canales estatales rusos obtienen ganancias, algunos analistas han estimado que el Kremlin generó US$27 millones en ingresos publicitarios solo gracias a YouTube entre 2017 y 2018, mientras que se estima que YouTube ganó US$22 millones por cuenta propia.

Desde el estudio de CCDH, la empresa matriz de Facebook, Meta, ha tomado medidas enérgicas. La semana pasada impidió que los medios estatales rusos compraran anuncios en sus servicios, y esta semana dijo que “restringiría el acceso” a RT y Sputnik en toda la UE, “dada la naturaleza excepcional de la situación actual”.

YouTube también eliminó temporalmente la capacidad de RT de ganar dinero con los anuncios que se muestran en su canal, y citó las mismas “circunstancias extraordinarias”.

“La guerra es solo otra cosa que pueden monetizar”

Aparte del conflicto de Ucrania, todos estos ejemplos de desinformación tienen algo en común: su éxito está habilitado y es recompensado por las funciones e incentivos integrados en las principales redes sociales.

Y mientras que los likes de RT tienen un fin geopolítico claro, los estafadores de las transmisiones en vivo de TikTok y las “páginas de guerra” de Instagram parecen simplemente haber encontrado una nueva aplicación para la verdad del siglo XXI de que cualquier audiencia en línea lo suficientemente grande puede generar ganancias.

Richards dice que algunos de los estafadores de las transmisiones en vivo probablemente tengan un motivo financiero, pero es posible que otros simplemente quieran llamar la atención. “Es totalmente posible que la gente lo esté haciendo solo por los seguidores. Eso es algo que la gente quiere en esta extraña distopía en la que vivimos”.

En cualquier caso, su comportamiento difiere de las personas que realmente tienen éxito como influencers en TikTok, porque ellos no generan ningún tipo de lealtad o de seguidores para el largo plazo.

Mientras tanto, el administrador de una página de guerra de Instagram declaró para Input: “Lo que estoy tratando de hacer es traer la mayor cantidad de personas posible a esta plataforma. Si surge una oportunidad para beneficiar a Ucrania, no puedo hacerlo hasta que tenga la cantidad de ojos que quiero tener allí”.

Jackson Weimer, un creador de memes de Instagram, tuvo una visión más fulminante: “La guerra es solo otra cosa que estas cuentas de memes pueden monetizar”.

Ahmed dice algo similar sobre los medios estatales rusos en Facebook. “La mayoría de la gente no usa [Facebook] para difundir mentiras deliberadas que socavan la vida humana”, dice, pero argumenta que los métodos de promoción de RT están “usando Facebook en la forma en que la empresa pretende que se use y permite que se use”.

Facebook ha dicho durante mucho tiempo que tiene IA (inteligencia artificial) que detecta signos de contenido engañoso o divisivo y que “baja de categoría” ese contenido en su feed. Los sistemas automatizados y los reportes de los usuarios marcan las publicaciones para que su ejército de más de 15,000 moderadores humanos las verifique.

Si bien no prohíbe la “información falsa” per se, durante la pandemia lentamente ha ido prohibiendo cada vez más información falsa que cree que representa una amenaza directa para la seguridad pública, incluida la información falsa sobre las vacunas y las elecciones.

TikTok ha dado menos detalles sobre sus esfuerzos. Un portavoz comentó para The Independent: “Seguimos monitoreando de cerca la situación, con mayores recursos para responder a las tendencias emergentes y eliminar el contenido infractor, incluida la información falsa dañina y la promoción de la violencia”.

“También nos asociamos con organizaciones independientes de verificación de datos para ayudar aún más en nuestros esfuerzos para contribuir a que TikTok siga siendo un lugar seguro y auténtico”.

La compañía también dice que evita que algunos contenidos, como vídeos de “spam”, “engañosos” o “sin fundamento”, así como con violencia gráfica, se recomienden en su feed algorítmico principal. Algunos tipos de vídeos se escanean con IA y se eliminan automáticamente al subirlos si es probable que infrinjan las reglas.

Sin embargo, Richards dice que, en general, la moderación de TikTok sigue siendo una “caja negra”, y dice que tiene “algunas de las mejores políticas que existen”, pero que a menudo tiene dificultades para hacerlas cumplir.

“¿Cómo se están volviendo tan grandes estos vídeos cuando se puede comprobar de manera tan sencilla que algunos de ellos son falsos?”, ella pregunta. “Podrían estar haciendo más para poner algunas barreras que intenten ralentizar estos vídeos que se vuelven virales de la noche a la mañana”.

.jpeg?quality=75&width=230&crop=3%3A2%2Csmart&auto=webp)

Bookmark popover

Removed from bookmarks