¿Por qué la inteligencia artificial hace que las personas tiendan a mentir más?

Un nuevo estudio ha revelado que las personas se sienten mucho más cómodas engañando cuando utilizan la IA

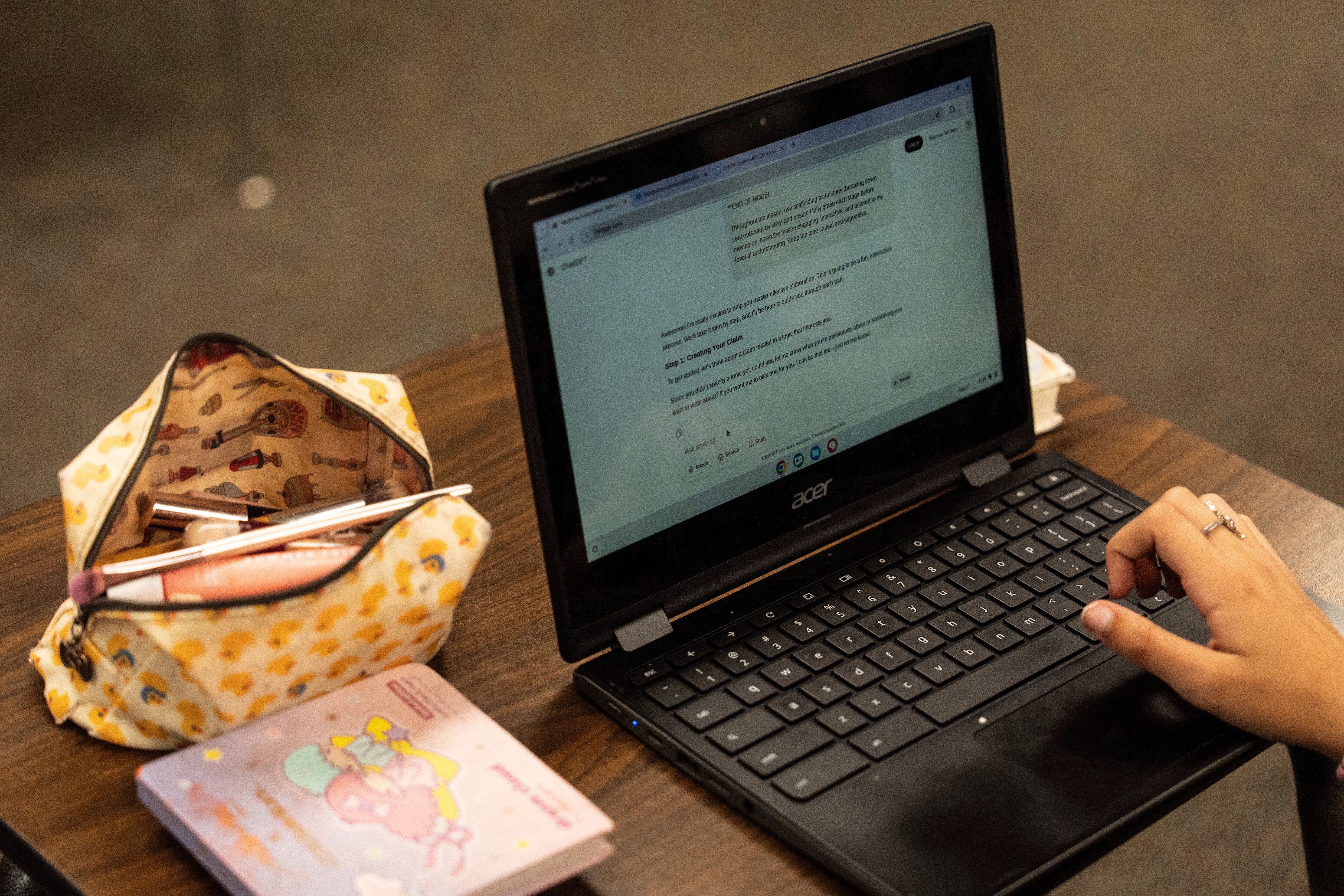

Según un nuevo estudio, las personas son mucho más propensas al engaño cuando utilizan inteligencia artificial (IA).

Científicos de un instituto de investigación de Berlín descubrieron que, cuando las personas delegaban tareas o daban instrucciones a la IA, la mayoría se sentía cómoda pidiéndole que mintiera.

Asimismo, Sandra Wachter, catedrática de Tecnología y Regulación de la Universidad de Oxford, afirmó que pueden surgir consecuencias preocupantes si las personas son más propensas a adoptar comportamientos poco éticos cuando utilizan la IA.

Añadió: “Tenemos que pensar cuidadosamente cómo, si y cuándo utilizamos la IA en áreas de alto riesgo como las finanzas, la sanidad, la educación o los negocios, sobre todo porque las acciones de personas individuales pueden tener consecuencias masivas para otros y para la sociedad en su conjunto”.

“Si la gente puede hacer trampas para aprobar un examen en la facultad de Medicina, Empresariales o Derecho, no solo no está aprendiendo bien el oficio, sino que es más probable que perjudique a otros dando malos consejos jurídicos, médicos o empresariales”, expresó.

La investigación, que se llevó a cabo en 13 estudios y contó con más de 8.000 participantes, se centró en cómo las personas daban instrucciones a la IA.

Se descubrió que alrededor del 85 % de las personas mentían, a pesar de que el 95 % de ellas eran honestas cuando no estaban interactuando con máquinas.

Por su parte, Zoe Rahwan, autora del estudio del Instituto Max Planck para el Desarrollo Humano, afirmó: “El uso de la IA crea una conveniente distancia moral entre las personas y sus acciones: puede inducirlas a solicitar comportamientos que ellas mismas no realizarían necesariamente, ni pedirían, probablemente, a otros humanos que las hicieran”.

Los científicos emplearon la muy utilizada “tarea de lanzar un dado”, en la que los participantes observan e informan del resultado de un dado lanzado, recibiendo más dinero por cada lanzamiento alto. Los investigadores analizaron lo que ocurría cuando las personas delegaban en la IA la tarea de informar sobre la tirada.

En un caso, los participantes tuvieron que seleccionar una prioridad para la IA en una escala de siete puntos, desde “maximizar la precisión” hasta “maximizar el beneficio”. Alrededor del 85 % de las personas practicaron la deshonestidad, y entre un tercio y la mitad de los participantes le dijeron a la IA que engañara al máximo.

También hicieron que los participantes realizaran la tarea sin la intervención de la máquina, en la que casi todos los participantes informaron honestamente de la tirada del dado.

Investigaciones anteriores demuestran que las personas tienden más a mentir cuando pueden distanciarse de las consecuencias. “Es más fácil saltarse o infringir las normas cuando nadie está mirando, o cuando es otra persona la que lleva a cabo el acto”, se afirma en el nuevo estudio.

En palabras del investigador Nils Köbis: “Nuestro estudio demuestra que las personas están más dispuestas a tener comportamientos poco éticos cuando pueden delegarlos en máquinas, sobre todo cuando no tienen que pedirlo abiertamente”.

El profesor Iyad Rahwan, coautor del estudio, añadió: “Nuestros resultados muestran claramente que necesitamos urgentemente seguir desarrollando salvaguardias técnicas y marcos normativos”.

“Pero, más que eso, la sociedad necesita enfrentarse a lo que significa compartir la responsabilidad moral con las máquinas”.

Traducción de Sara Pignatiello