Un nuevo estudio de seguridad reveló la IA “más daniña”

Ninguna de las ocho principales empresas de IA obtuvo una buena puntuación cuando se evaluó el riesgo existencial

La mayoría de las empresas dedicadas a la inteligencia artificial no gestionan los riesgos catastróficos que conlleva esta tecnología, según un nuevo estudio.

La evaluación realizada por expertos en seguridad de la IA de la organización sin ánimo de lucro Future of Life Institute concluyó que las ocho principales empresas de IA “carecen de las salvaguardas concretas, la supervisión independiente y las estrategias creíbles de gestión de riesgos a largo plazo que exigen sistemas tan potentes”.

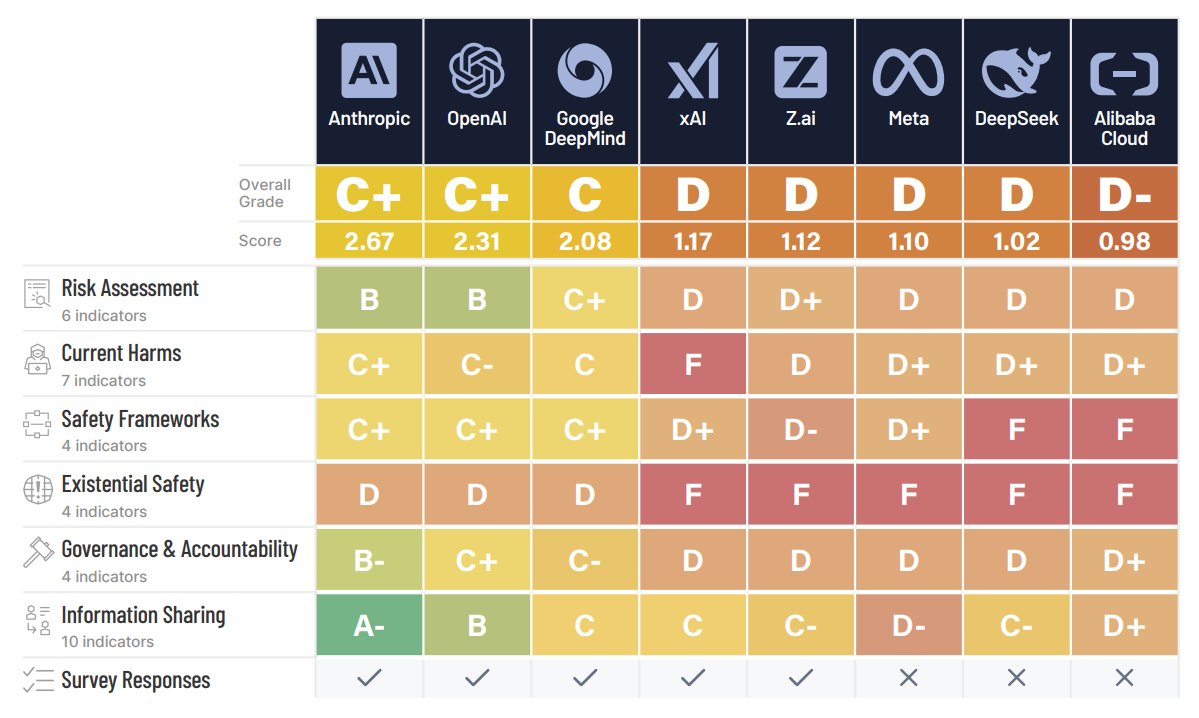

Las empresas estadounidenses obtuvieron las mejores puntuaciones en el Índice de Seguridad de la IA, con Anthropic por delante de OpenAI, creador de ChatGPT, y Google DeepMind. Las empresas chinas registraron las calificaciones globales más bajas, con Alibaba Cloud justo por detrás de DeepSeek.

Ninguna empresa obtuvo más de una D cuando se evaluó el riesgo existencial, mientras que Alibaba Cloud, DeepSeek, Meta, xAI y Z.ai obtuvieron una F.

"La seguridad existencial sigue siendo el principal fallo estructural del sector, por lo que la brecha cada vez mayor entre la aceleración de las ambiciones de AGI/superinteligencia y la ausencia de planes de control creíbles es cada vez más alarmante”, señala el estudio.

“Mientras las empresas aceleran sus ambiciones de AGI y superinteligencia, ninguna demostró un plan creíble para prevenir el mal uso catastrófico o la pérdida de control”.

Los autores del informe piden a las empresas de IA que sean más transparentes en sus propias evaluaciones de seguridad y que se esfuercen más por proteger a los usuarios de daños más inmediatos, como la psicosis de la IA.

“Los directores ejecutivos de IA afirman que saben cómo construir una IA sobrehumana, pero ninguno puede demostrar cómo evitarán que perdamos el control, tras lo cual la supervivencia de la humanidad ya no estará en nuestras manos”, afirma Stuart Russell, profesor de informática de la Universidad de Berkeley.

“Busco pruebas de que pueden reducir el riesgo anual de pérdida de control a uno entre cien millones, en línea con los requisitos de los reactores nucleares. En cambio, admiten que el riesgo podría ser de uno de cada 10, de uno de cada cinco, incluso de uno de cada tres, y no pueden justificar ni mejorar esas cifras”.

Un representante de OpenAI declaró que la empresa estaba trabajando con expertos independientes para “incorporar sólidas salvaguardias a nuestros sistemas y probar rigurosamente nuestros modelos”.

Un portavoz de Google señaló: “Nuestro Marco de Seguridad Fronteriza esboza protocolos específicos para identificar y mitigar los riesgos graves de los potentes modelos de IA fronteriza antes de que se manifiesten.

A medida que nuestros modelos son más avanzados, seguimos innovando en seguridad y gobernanza al ritmo de las capacidades”.

The Independent se comunicó en busca de comentarios con Alibaba Cloud, Anthropic, DeepSeek, xAI y Z.ai.

Traducción de Olivia Gorsin

Bookmark popover

Removed from bookmarks